Обзор технологии G-Sync: меняем правила игры. Как отключить вертикальную синхронизацию в видеокарте Ограничение фпс для работы g sync

Что такое G-Sync/FreeSync, чем отличаются от V-Sync и зачем все это нужно?

Прочитал пост Решение проблемы с низким FPS в No Man’s Sky. Там рассказывается о том, что пользователь Steam под ником xandrohouse нашел заветный параметр в недрах конфигурационного файла, переключив который в “false” можно увеличить FPS до небес. Тут же пошли комментарии про кривизну рук разработчиков и плохую оптимизацию. Не берусь судить, т.к. в игру не играл, по этой же причине не буду спорить о ценности игры для игровой индустрии в целом, но вот что такое G-Sync, чем он отличается от V-Sync и с чем это все едят попробую разобраться.

Писать буду максимально упрощенно и постараюсь не влезать в дебри.

И так, начнем с FPS. FPS (Frame per Seconds) – количество кадров “генерируемых” графическим процессором в секунду – основной объект “дрочерства”. Алгоритм тут простой – чем больше FPS – тем лучше. Высокий FPS делает изображение более четким, уменьшает отклик между действием игрока и отображением результатов этого действия на мониторе. В общем это благоприятно сказывается на картинке и делает игру более зрелищной.

В подавляющем большинстве современных игр FPS переменный. Т.е. он может “прыгать” от сцены к сцене и зависеть от того, что происходит в игре. Это связано с тем, что ресурсы графического процессора ограничены, по этому чем больше ему надо “отрисовать” тем медленнее он это будет делать и FPS падает. Можно вывести некий минимальный порог, ниже которого падение FPS будет доставлять реальное неудобство. Порог этот находится в районе 30 FPS. Нужно понимать, что это субъективное значение. Оно будет зависеть не только от конкретного человека, но и от того что происходит на экране. Скажем если сцена не содержит быстро движущихся объектов есть вероятность что вы не отличите 5 FPS от 30.

Мониторы отрисовывают изображение по кадрам. При этом монитору требуется на это определенное время. В упрощенном варианте время это буде зависеть от скорости реакции ЖК-матрицы, чем меньше время реакции, тем больше кадров в секунду может показать монитор.

Отлично, у нас есть GPU который выдаёт нам 100500 FPS. Но тут мы сталкиваемся с жестокой реальностью. А наш монитор может отобразить нам все эти FPS? Как правило ответ “нет, не может”. Подавляющее большинство современных ЖК-мониторов, представленных на массовом рынке, больше 30 кадров в секунду не показывают.

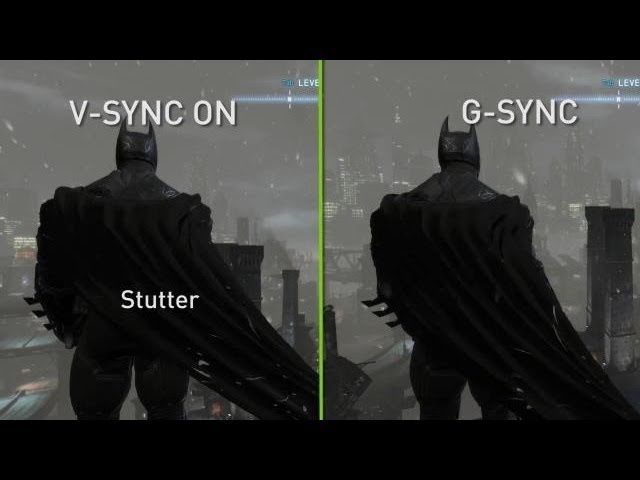

Если частота кадров GPU не совпадает с частотой кадров монитора появляются артефакты изображения – “разрыв изображения” или “подёргивание изображения”. Особенно этот эффект заметем при быстрых движениях игровой камеры. Происходит это из-за того, что монитор не успевает обновить изображение. В то время, как он показывает кадр А, к нему “приходит” кадр Б, который он тут же начинает отрисовывать. Получается, что одна часть монитора отображает кадр А, а другая уже отображает кадр Б – кадры накладываются друг на друга. Результат такой несогласованности на картинке (здесь особо запущенный случай – наложилось 3 кадра).

Она же “вертикальная синхронизация”. Идея простая – ограничить верхнюю границу FPS для GPU частотой кадров монитора. Теперь ваша видеокарта будет генерировать кадров не больше, чем может отобразить ваш монитор. Проблема “разрывов” и “подёргиваний” изображения решена, вроде бы.

Но реальность опять наносит удар. Дело в том, что частота смены кадров монитора величина тоже нифига не постоянная (мы про ЖК-мониторы) и будет зависеть от цветовой гаммы кадра. Если вы видите на коробке монитора надпись “время отклика 8 мс” то знайте, что это время, которое потребуется пикселю, что бы переключится между серым с 90% яркостью, до серого с 10% яркостью (так называемое GtG). Если цвета перехода будут другие, то и время будет другое. Для некоторых случаев оно может достигать и 30 мс. Существует так называемое “среднее время полной реакции монитора”, что бы его прикинуть можете смело “коробочные” 8 мс (или что там у вас) умножить на 2.

И так, ка же быть раз все так непостоянно? Решение простое – надо дождаться когда монитор отрисует кадр, и только после этого отправлять ему новый. Именно так подумали в Nvida и придумали G-Sync (в AMD тоже подумали и придумали аналогичную и назвали её FreeSync) . Теперь видеокарта передает монитору новый кадр только после того, как монитор “сообщил” что отрисовал предыдущий. Есть только одно НО: монитор тоже должен поддерживать G-Sync/FreeSync.

1. Нет смысла подключать свою GTX 1080 за 50 косарей к монитору за 5. Сколько бы она не сгенерировала вам FPS больше 30 вы не увидите никогда;

2. Нет смысла отключать V-Sync/G-Sync, т.к всего скорее это приведет к ухудшению изображения (хотя и почешет ваше ЧСВ “заоблачными” показателями FPS, выдаваемым вашей видеокартой);

Нужен ли G Sync? Все, что вам нужно знать о технологии Nvidia

Нужен ли G Sync? Все, что вам нужно знать о технологии Nvidia

G Sync — все говорят об этом, все хотят этого, но все ли знают, что это на самом деле? Не секретное оружие Nvidias в гонке игровых вооружений теперь дешевле, чем это было пару лет назад, поэтому сейчас самое время немного подумать и спросить, стоит ли его наконец то купить. Нужен ли G Sync? Все, что вам нужно знать о технологии Nvidia

Здесь есть все, что вам нужно знать.

Как работает G-Sync

Для Чтобы понять G-Sync, мы должны сначала понять V-sync и его ограничения.

Вы, вероятно, знакомы с чем-то, что называется V-sync. (Мы написали об этом целую статью.) Это ограничивает частоту кадров в игре частотой обновления вашего монитора. Так что если у вас монитор 60, 75 или 120 Гц, частота кадров в игре будет максимальной.

Это крайне важно для предотвращения прерывистых разрывов экрана, которые появляются на экране во время игр, когда графический процессор воспроизводит кадры с другой скоростью, чем монитор, буферизующий их.

Но есть компромисс для V-синхронизации. В наши дни компьютеры выстраивают изображения для отправки на монитор, используя двойную и тройную буферизацию, по существу, подготавливая один или два кадра, пока другой отображается на экране.

Чтобы предотвратить разрыв экрана, v-sync вызывает крошечные задержки в процессе буферизации, чтобы убедиться, что монитор готов к следующему кадру, что может вызвать задержку ввода.

Кроме того, если вы используете только двойную буферизацию (как в большинстве игр), то вы можете наблюдать большие падения FPS. (Это проблема, только если ваша видеокарта не способна выводить видео с постоянной высокой частотой кадров в данной игре.)

Итак, G-Sync

Что ж, это была длинная преамбула , но это делает объяснение G-Sync намного быстрее.

Монитор с поддержкой G-Sync способен выводить VRR (переменную частоту обновления), постоянно адаптируясь к частоте рендеринга кадров ваших видеокарт Nvidia (G-Sync является Технология Nvidia, поэтому она эксклюзивна для видеокарт Nvidia).

Это полностью исключает разрыв экрана, поскольку частота рендеринга кадров графического процессора никогда не превышает частоту обновления монитора, сводит на нет резкие падения FPS, которые вы видите с помощью vsync, и уменьшает задержку ввода, поскольку монитор больше не удерживает буферизацию.

Стоит ли того G-Sync?

Во-первых, это зависит от того, насколько вы хардкорный игрок и какие игры вы делаете. G-Sync создает идеальное сочетание низкой задержки ввода и более стабильной производительности без разрывов, но, возможно, в любом случае вы действительно не страдаете от этих проблем.

Если у вас топовая видеокарта с обычным vsync Если вы включите, то вы получите желаемую производительность и стабильную частоту кадров даже на мониторе без G-Sync.

Вы можете страдать от увеличения входной задержки / задержки, но степень этого зависит от вашего монитора.Производители, как правило, не сообщают о задержке ввода для своих дисплеев, но этот удобный веб-сайт может помочь вам определить задержку на вашем мониторе.

G-Sync теперь совместим с мониторами FreeSync

Nvidia недавно сделала приветственный шаг, чтобы сделать G-sync более доступным для геймеров. В январе 2019 года Nvidia объявила, что выпустит обновление драйвера, которое позволит его графическим процессорам работать с монитором FreeSync. FreeSync в основном эквивалентен AMD G-sync, но теперь, когда этот патч вышел, вам не нужно будет использовать AMD GPU, чтобы воспользоваться преимуществами монитора, содержащего технологию адаптивной частоты обновления FreeSync.

Для бизнеса это делает Nvidia имеет смысл сделать это, поскольку потребители не будут направлены на покупку графических процессоров AMD для своих мониторов FreeSync. Но это также хорошая новость для потребителей, потому что мониторы FreeSync, как правило, намного дешевле, чем мониторы G-Sync, поэтому точка входа, чтобы настроить себя с помощью G-Sync, становится дешевле.

Nvidias объявила только 12 существующих FreeSync пока что мониторы официально совместимы с G-Sync, но это число должно очень быстро возрасти. Следите за лейблом G-Sync, совместимым с этого момента.

Заключение

Доступность G-Sync значительно возросла за последний год или около того.Даже недорогие низкоуровневые графические процессоры Nvidia (если это GeForce GTX 650 Ti или более поздняя версия с G-Sync) способны к G-Sync, и тот факт, что все больше и больше мониторов FreeSync становятся совместимыми с G-Sync. Что делает его отличное время, чтобы следить за рынком.

Если у вас высокопроизводительный графический процессор, способный стабильно максимизировать частоту обновления вашего монитора, то вы в окружении людей, которые меньше всего заметят разницу при обновлении до G-Sync.

Если, однако, у вас есть графический процессор с поддержкой G-Sync и вы все равно хотите обновить свой монитор, то монитор G-Sync (или FreeSync) абсолютно не представляет сложности.

Вопрос о том, является ли G- Sync (или его двоюродный брат AMD, FreeSync) стоит того, чтобы стать спорным для геймеров через пару лет. Все новые графические процессоры производства Nvidia теперь имеют встроенную технологию. И мониторы, использующие эту технологию, становятся все дешевле и дешевле.

Если вы преданный игрок, владелец графического процессора Nvidia и хотите улучшить это качество. жизненные проблемы, такие как разрыв экрана и задержка ввода, а затем самое подходящее время для прыжка на борт.

Разбираемся, что такое G-Sync, FreeSync, V-Sync и нужны ли они вообще

Связь видеокарты с монитором и её проблемы

В идеальном случае эти два отрезка времени должны быть равны — тогда, когда на мониторе закончится старый кадр, к нему подоспеет новый кадр и они плавно пойдут друг за другом, не создавая проблем. Но видеокарта может «обгонять» монитор.

И тут необходимо понимать, что мониторы работают с определёнными частотами обновления — количеством обновления кадров в секунду. Измеряется частота обновления в герцах. Мониторы с 60 Гц обновляют картинку 60 раз за секунду, 144 Гц — 144 раза за секунду.

Возвращаясь к видеокарте и монитору — значение кадров в секунду, выходящих из видеокарты, плавает, и может быть как меньше 60, так и больше. Оба случая приводят к проблемам.

Если кадры «тяжёлые» (большой взрыв трёх машин в 4K-разрешении, например), то рендер будет долгим и видеокарта может выдать меньше 60 кадров за секунду. Из-за этого монитору не хватает кадров, чтобы воспроизвести одну секунду, и игра компенсирует это и формирует кадры, где действие проходит быстрее, чтобы игровой процесс не замедлился. Но потом «тяжёлые» кадры проходят, и время рендера становится прежним. Но игра ещё не успела перестроиться и по-прежнему заставляет рендерить ускоренные кадры — из-за чего в какой-то момент может пойти смещение и возникнет статтер. Пример работы такого алгоритма — ниже (в верхней части ролика все кадры рендерятся за одинаковое время, в нижней время колеблется).

Обратный вариант: видеокарта рендерит больше кадров в секунду, чем способен показать монитор. Это приводит к тому, что на мониторе может появиться сразу несколько кадров.

Подобные разрывы бросаются в глаза, и их частое появление может вызвать тошноту, боль в глазах или головокружение. В таком случае речь идёт не просто о плавной игре, но и о здоровье человека, потому борьбе с подобным уделено большое внимание. Ниже рассмотрены методы синхронизации видеокарты и монитора, которые позволяют избавиться от подобных проблем.

Вертикальная синхронизация — дёшево и сердито

Тем не менее, не решается проблема и с кадрами, которые рендерятся дольше и из-за которых видеокарта выдаёт в секунду меньше, чем может показать монитор. Потому что V-Sync в таком случае сокращает число выводимых кадров до кратного частоте монитора. Например, если у вас монитор с 60 Гц, а видеокарта выводит 55 кадров в секунду, то V-Sync срежет выводимое число кадров до 30, чтобы картинка шла плавнее. В результате FPS падает и ощущения становятся ещё хуже.

Адаптивная синхронизация — старший брат V-Sync

Однако на практике подобный метод помогает не всегда и проблемы вертикальной синхронизации всё ещё могут встречаться.

G-Sync — дорого, но эффективно

Убирая все минусы вертикальной синхронизации (статтеринг, разрыв изображения, задержку управления), G-Sync является очень хорошим вариантом. Но, вместе с этим, очень дорогим, так как G-Sync работает только на мониторах с предустановленным чипом от Nvidia и требует повышенной мощности.

FreeSync — упрощённая G-Sync

Однако свои отличия есть. Если G-Sync продолжает работать по этому принципу на низких FPS, мониторы с FreeSync начинают использовать «традиционные» методы синхронизации, возвращая старые помехи — и статтер, и разрыв изображения, и задержку управления.

Но если G-Sync использует свой собственный чип, FreeSync работает на DisplayPort — уже разработанной до этого технологии. Говоря кратко: для FreeSync тоже нужен специальный монитор, но FreeSync-монитор будет дешевле монитора с G-Sync.

VRR и совместимость FreeSync с G-Sync

Это значительно расширяет список подходящих мониторов, а также даёт шанс, что любой монитор сможет работать с G-Sync.